Η NVIDIA μοιράστηκε τα πρώτα σημεία αναφοράς της GPU Blackwell σε φόρτους εργασίας MLPerf v4.1 AI Training, παρέχοντας 2,2x κέρδος έναντι του Hopper.

Η NVIDIA καταρρίπτει τον ανταγωνισμό με τις GPU της Blackwell, αποδίδοντας έως και 2,2x κέρδος στα σημεία αναφοράς εκπαίδευσης AI MLPerf v4.1 έναντι Hopper

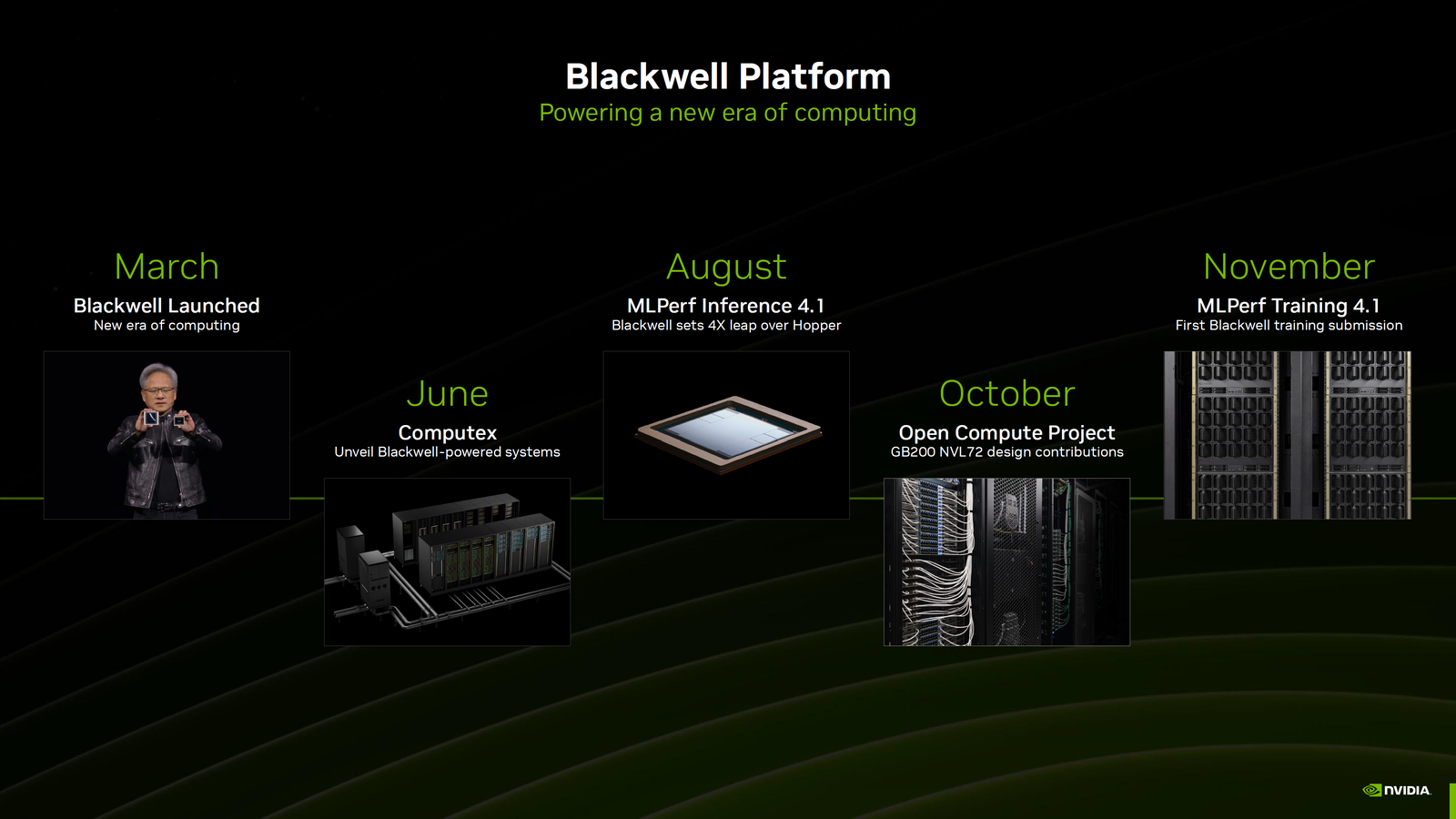

Τον Αύγουστο, το Blackwell της NVIDIA έκανε το ντεμπούτο του στα σημεία αναφοράς MLPerf v4.1 AI Inference, επιδεικνύοντας ισχυρές βελτιώσεις απόδοσης σε σχέση με τα τελευταίας γενιάς τσιπ Hopper και επίσης ενάντια στον ανταγωνισμό. Σήμερα, η NVIDIA μοιράζεται τα πρώτα σημεία αναφοράς Blackwell στους φόρτους εργασίας MLPerf v4.1 AI Training που παρουσιάζουν εκπληκτικά αποτελέσματα.

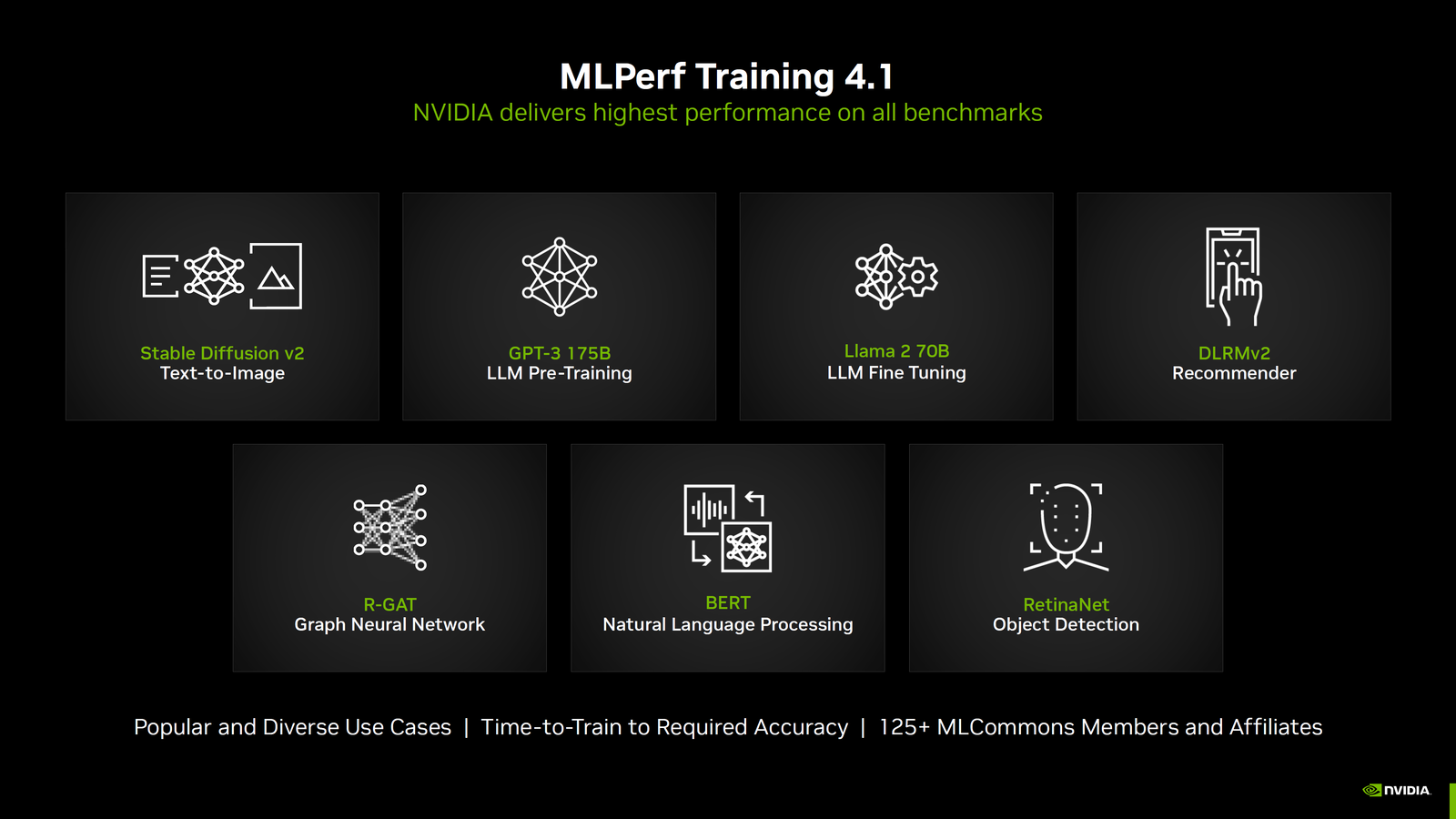

Η NVIDIA δηλώνει ότι η ζήτηση για υπολογιστές στον τομέα της τεχνητής νοημοσύνης αυξάνεται σε εκθετική κλίμακα με την κυκλοφορία νέων μοντέλων. Αυτό απαιτεί τόσο ταχεία εκπαίδευση όσο και ικανότητες εξαγωγής συμπερασμάτων. Οι φόρτοι εργασίας των συμπερασμάτων συγκρίθηκαν πριν από μερικούς μήνες και ήρθε η ώρα να εξετάσουμε τα τεστ εκπαίδευσης που περιλαμβάνουν το ίδιο σύνολο φόρτων εργασίας, όπως:

- Llama 2 70B (LLM Fine-Tuning)

- Σταθερή διάχυση (Κείμενο σε εικόνα)

- DLRMv2 (Σύστημα)

- BERT (NLP)

- RetinaNet (Ανίχνευση αντικειμένων)

- GPT-3 175B (Προεκπαίδευση LLM)

- R-GAT (Graph Neural Network)

Αυτές είναι μερικές από τις πιο δημοφιλείς και ποικίλες περιπτώσεις χρήσης για την αξιολόγηση της απόδοσης AI Training των επιταχυντών AI και όλες αξιολογούνται στις δοκιμές MLPerf Training 4.1. Αυτοί οι φόρτοι εργασίας είναι πολύ ακριβείς όσον αφορά τον χρόνο προπόνησης (σε λεπτά) για την απαιτούμενη αξιολόγηση και έχουν 125+ μέλη MLCommons στην κοινοπραξία και θυγατρικές που τους υποστηρίζουν για να ευθυγραμμίσουν τις δοκιμές με την αγορά.

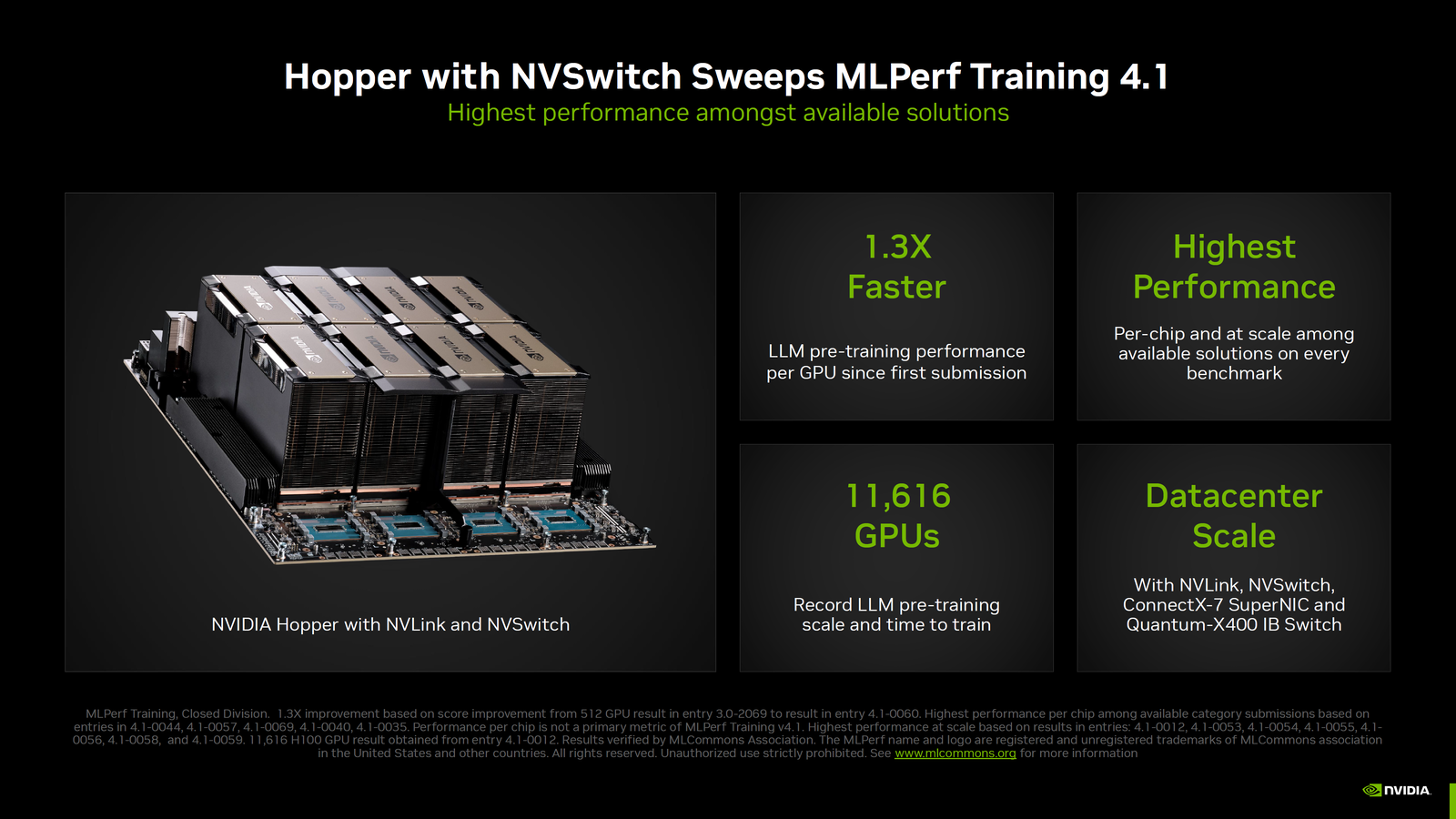

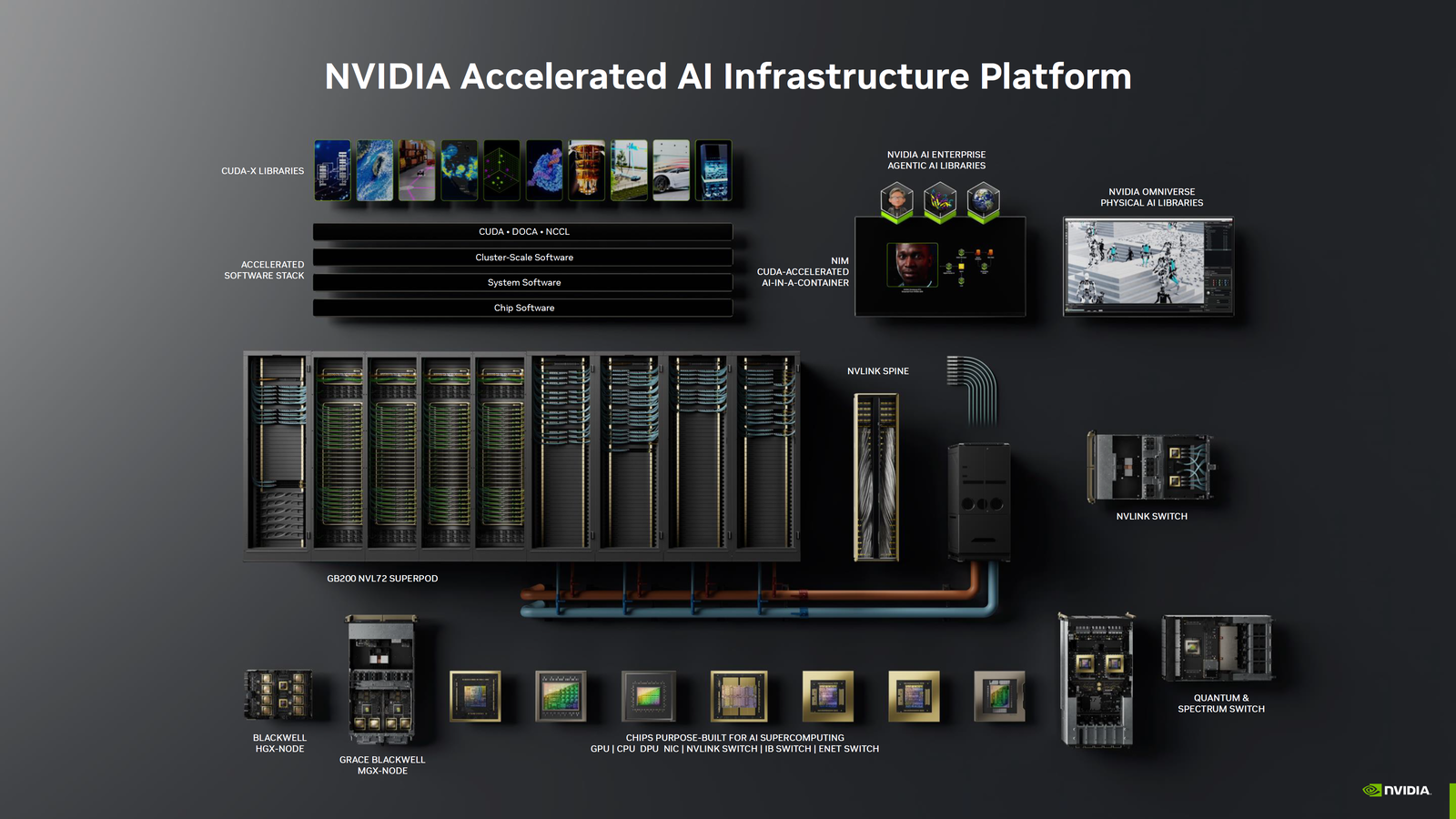

Ξεκινώντας πρώτα με το Hopper, οι GPU H100 είναι τώρα 1,3 φορές πιο γρήγορες σε απόδοση προ-εκπαίδευσης LLM ανά GPU από την πρώτη τους υποβολή και προσφέρουν την υψηλότερη απόδοση στην Εκπαίδευση AI μεταξύ της στοίβας τσιπ που είναι διαθέσιμα σε κάθε σημείο αναφοράς. Με το Hopper, η NVIDIA έκανε επίσης την υψηλότερη υποβολή σε κλίμακα για το MLPerf χρησιμοποιώντας 11.616 GPU Hopper H100 και τα τσιπ είναι σε κλίμακα κέντρου δεδομένων χρησιμοποιώντας διακόπτες NVLink, NVSwitch, ConnectX-7 SuperNIC και Quantum-X400 IB.

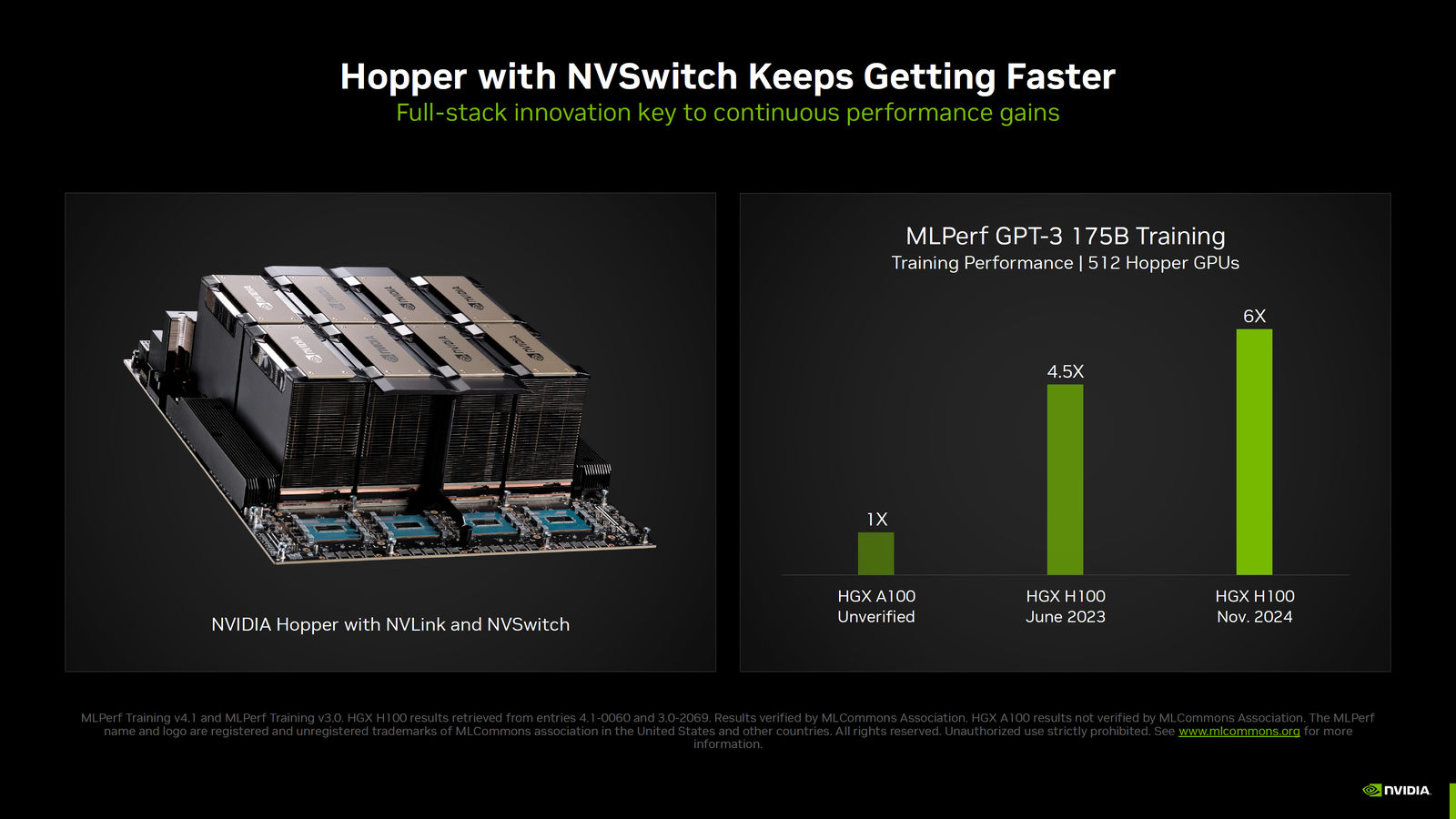

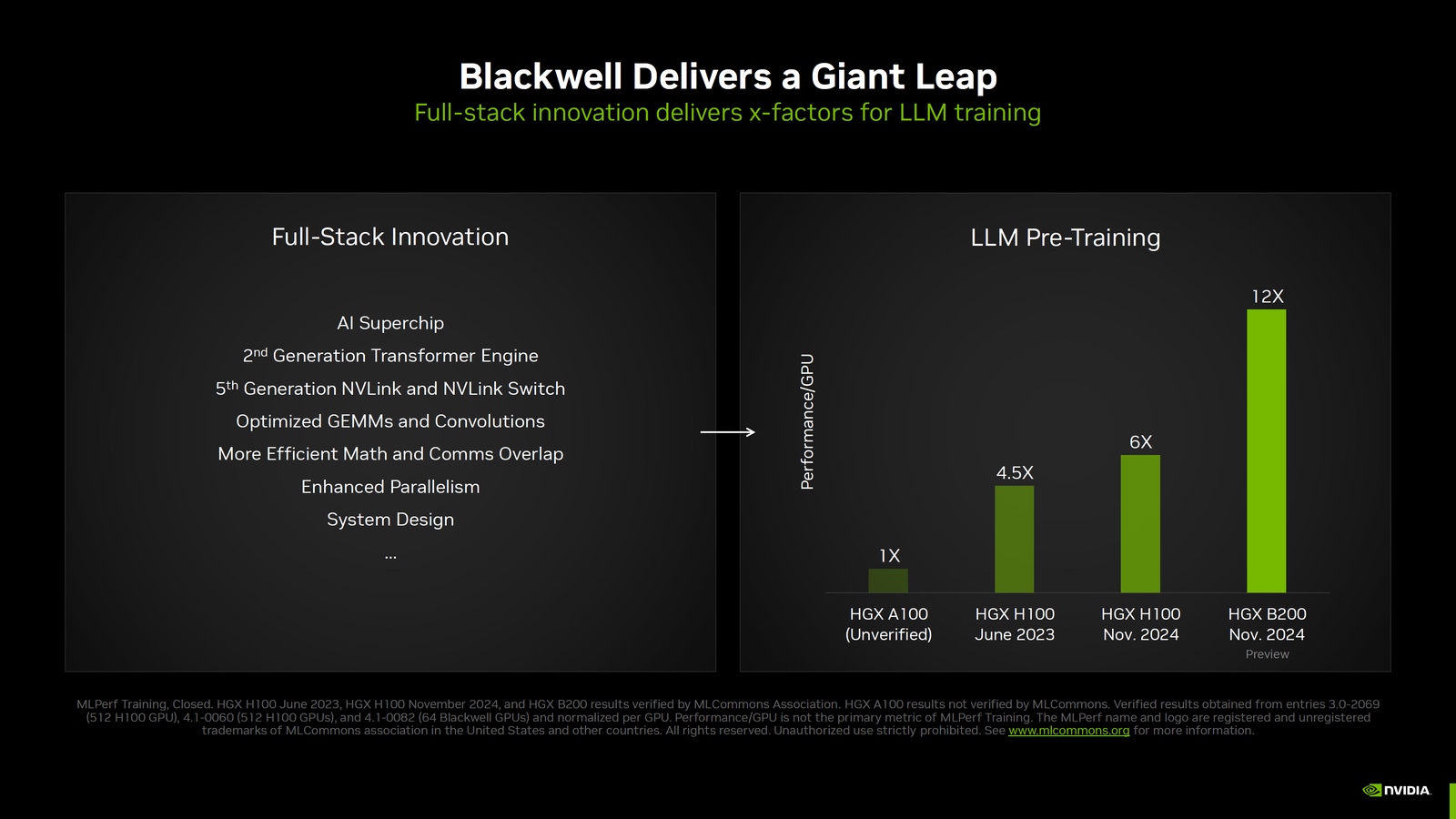

Από την κυκλοφορία, οι GPU της NVIDIA Hopper έχουν αυξηθεί σε απόδοση χάρη στις συνεχείς βελτιστοποιήσεις λογισμικού εντός της στοίβας CUDA AI, προσφέροντας τώρα 6x αύξηση στην απόδοση έναντι του HGX A100 και 70% αύξηση σε σχέση με την υποβολή του HGX H100 τον Ιούνιο του 2023 στο GPT-3 (175B Training) με χρήση 512 GPU σε κάθε σύνολο υποβολής.

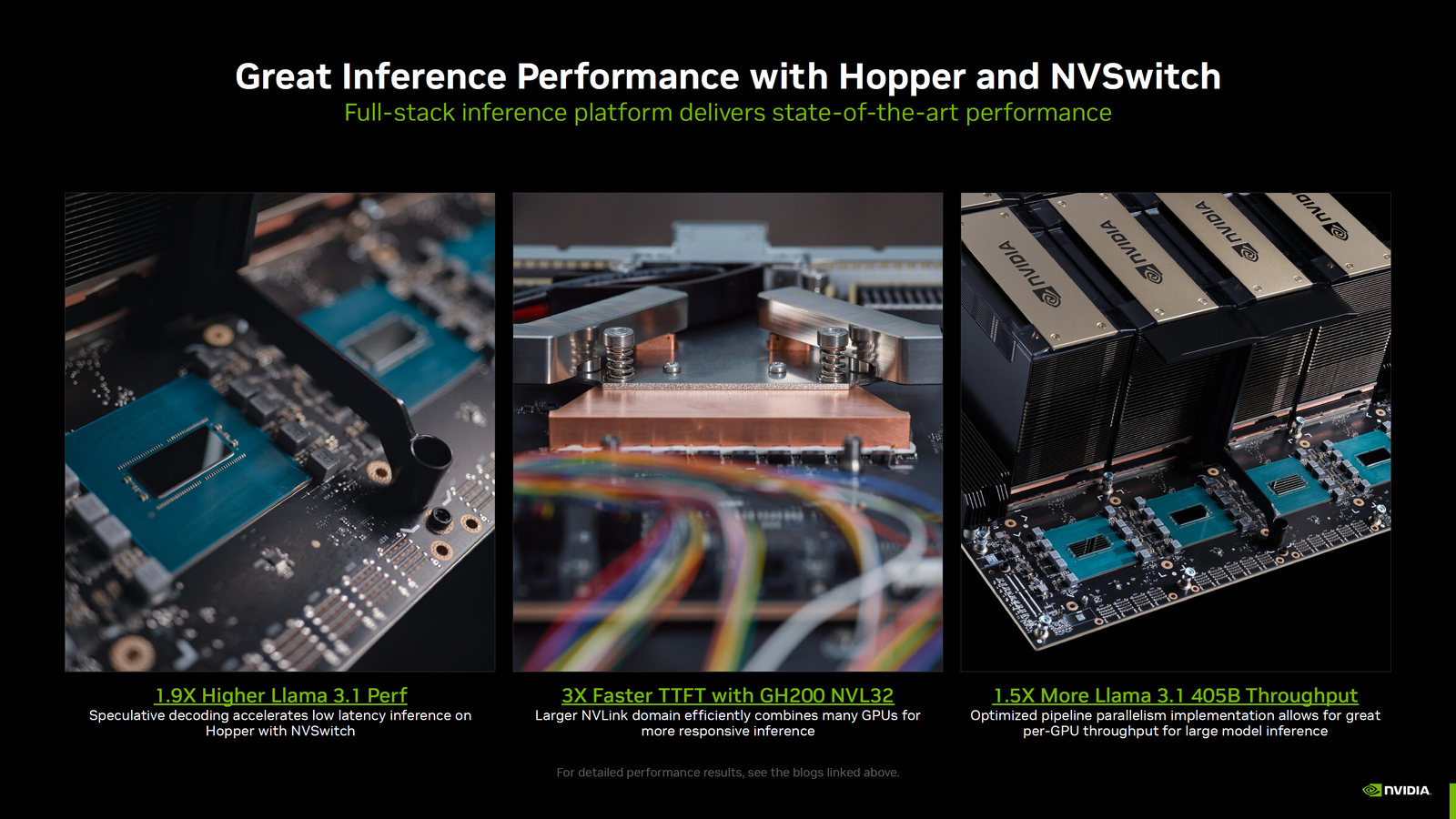

Στρογγυλοποιώντας τα προηγούμενα σημεία αναφοράς Hopper Inference, τα τσιπ προσφέρουν 1,9 φορές υψηλότερη απόδοση στο Llama 3.1, 3 φορές ταχύτερα στο TTFT με GH200 NVL32 και 1,5 φορές ταχύτερη απόδοση στο Llama 3.1 405B, κάτι που δείχνει για άλλη μια φορά τις συνεχείς καινοτομίες στη στοίβα λογισμικού.

Υπάρχει ένας λόγος που ο ανταγωνισμός δυσκολεύεται να ανταγωνιστεί τον Hopper με τις νέες μάρκες του, πόσο μάλλον τον Blackwell.

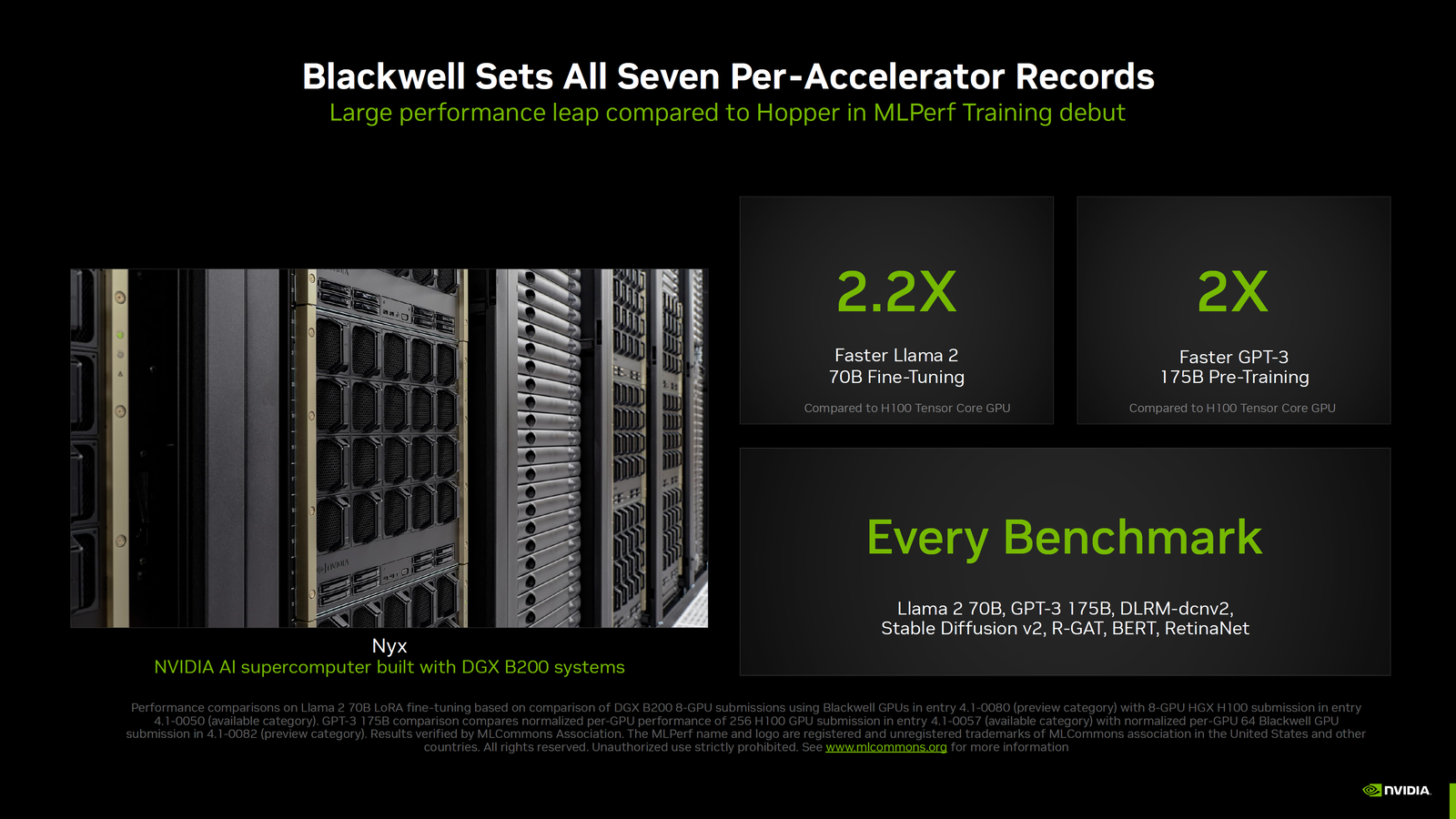

Αυτό μας φέρνει στο Blackwell, την καρδιά των κέντρων δεδομένων AI επόμενης γενιάς. Αμέσως μετά, η NVIDIA έχει διεκδικήσει επτά ρεκόρ ανά επιταχυντή χρησιμοποιώντας τον υπερυπολογιστή της Nyx AI, ο οποίος είναι κατασκευασμένος με συστήματα DGX B200.

Αυτός ο υπερυπολογιστής προσφέρει 2,2 φορές γρηγορότερη απόδοση Llama 2 70B (Fine-Tuning) έναντι Hopper H100, 2 φορές γρηγορότερη απόδοση GPT-3 175B (Pre-Training) έναντι Hopper H100, και επίσης συντρίβει ολόκληρο το σύνολο των φόρτων εργασίας στο MLPerf Training .

Με το Blackwell, η NVIDIA όχι μόνο διπλασιάζει την απόδοση, αλλά φέρνει ένα προηγμένο σύνολο τεχνολογιών τις οποίες αναλύσαμε στην πλήρη κατάδυση που παρέχεται κατά τη διάρκεια του Hot Chips 2024. Επιπλέον, οι συνεργάτες της NVIDIA επιδεικνύουν επίσης εξαιρετική απόδοση χρησιμοποιώντας τα συστήματα που βασίζονται σε Hopper και Έχουν γίνει συνολικά 11 υποβολές συνεργατών που δείχνει τη δυναμική που περιβάλλει τις GPU Hopper και Blackwell.

Η πρώτη υποβολή εκπαίδευσης Blackwell στην Κοινοπραξία MLCommons — η οποία δημιουργεί τυποποιημένες, αμερόληπτες και αυστηρά αξιολογημένες δοκιμές για τους συμμετέχοντες στον κλάδο — υπογραμμίζει τον τρόπο με τον οποίο η αρχιτεκτονική προωθεί την απόδοση της παραγωγικής εκπαίδευσης AI. Για παράδειγμα, η αρχιτεκτονική περιλαμβάνει νέους πυρήνες που κάνουν πιο αποτελεσματική χρήση των Tensor Cores. Οι πυρήνες είναι βελτιστοποιημένες, στοχευμένες μαθηματικές πράξεις, όπως πολλαπλασιασμοί μήτρας που βρίσκονται στην καρδιά πολλών αλγορίθμων βαθιάς μάθησης.

Η υψηλότερη υπολογιστική απόδοση ανά GPU και η σημαντικά μεγαλύτερη και ταχύτερη μνήμη υψηλού εύρους ζώνης της Blackwell της επιτρέπουν να εκτελεί το σημείο αναφοράς GPT-3 175B σε λιγότερες GPU, ενώ επιτυγχάνει εξαιρετική απόδοση ανά GPU.

Εκμεταλλευόμενοι τη μνήμη HBM3e υψηλότερου εύρους ζώνης, χρησιμοποιήθηκαν μόνο 64 GPU Blackwell στο σημείο αναφοράς GPT-3 LLM χωρίς συμβιβασμούς στην απόδοση ανά GPU. Το ίδιο σημείο αναφοράς που εκτελέστηκε με χρήση του Hopper χρειαζόταν 256 GPU για να επιτύχει την ίδια απόδοση.

μέσω NVIDIA

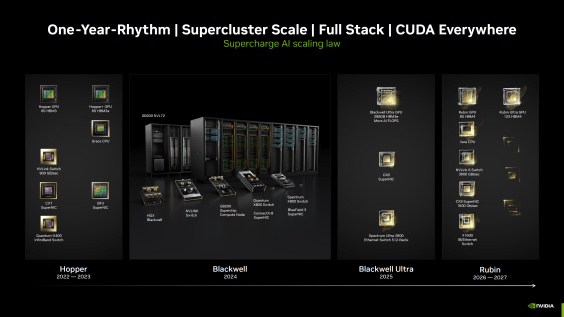

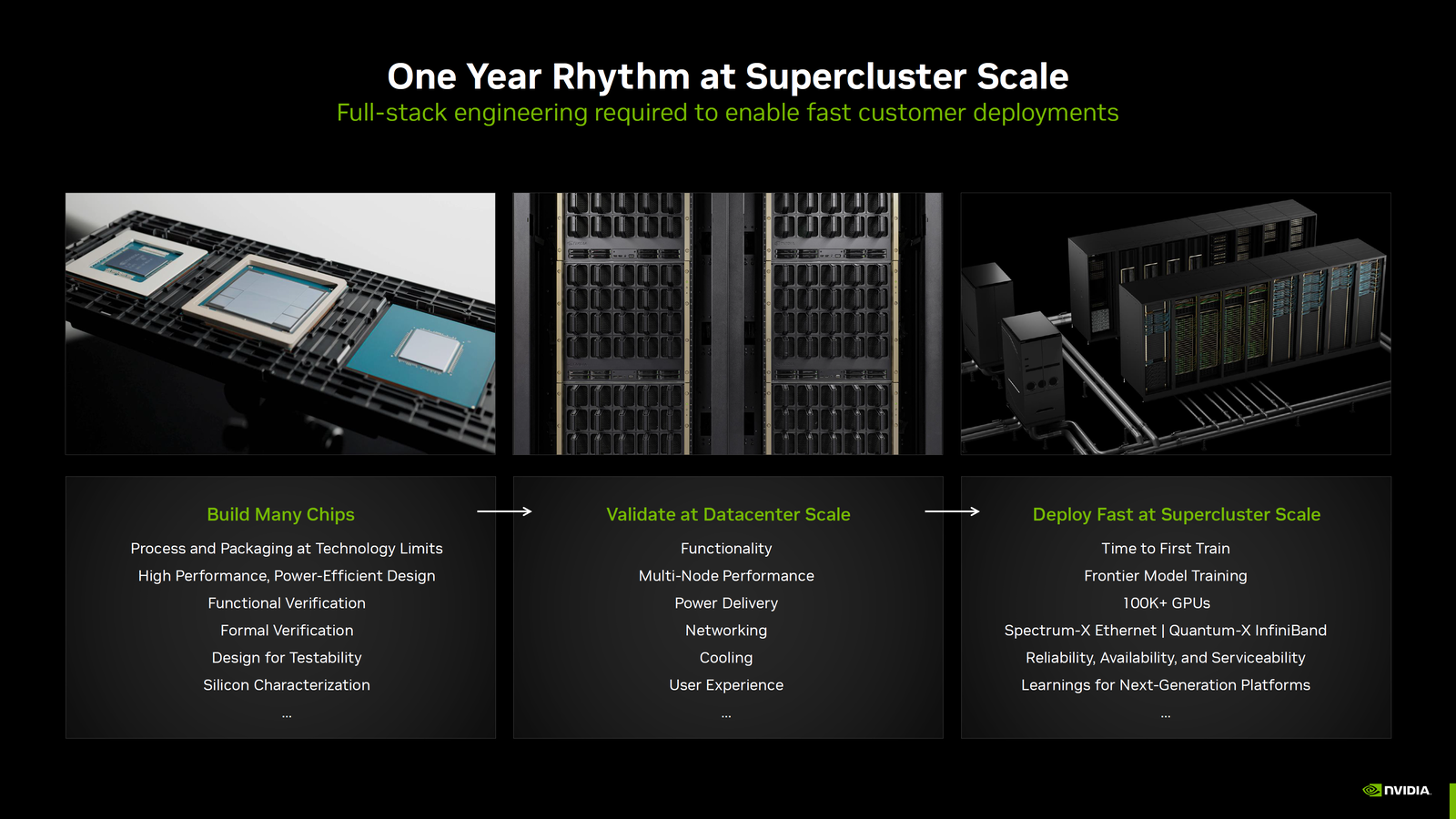

Η NVIDIA ρίχνει επίσης λίγο φως στον ετήσιο ρυθμό της, που δεν σημαίνει μόνο τη δημιουργία νέων τσιπ όσο το δυνατόν γρηγορότερα, αλλά και την επικύρωσή τους στην κλίμακα του κέντρου δεδομένων και την ταχύτερη ανάπτυξή τους στην κλίμακα super-cluster.

Η πράσινη ομάδα ξεκαθαρίζει ότι δεν είναι απλώς μια εταιρεία που κατασκευάζει τσιπ, αλλά είναι μια λύση κέντρου δεδομένων και πάροχος συστημάτων σε κλίμακα.

Αυτός είναι ο λόγος για τον οποίο η εταιρεία έχει ήδη μοιραστεί τον οδικό χάρτη τεχνητής νοημοσύνης επόμενης γενιάς που περιλαμβάνει το Blackwell Ultra ως συνέχεια του Blackwell με περισσότερη μνήμη (288 GB HBM3e) και περισσότερη υπολογιστική ιπποδύναμη το 2025. Η πλατφόρμα Blackwell Ultra αναμένεται να χρησιμοποιήσει την ονομασία B300 σύμβαση.

Η συνέχεια σε αυτό είναι με τη μορφή του Rubin, το οποίο έρχεται στην τυπική γεύση το 2026 με τις παραλλαγές 8S HBM4 και 12S HBM4 το 2027. Τέλος, η NVIDIA επιβεβαιώνει ότι η Blackwell βρίσκεται τώρα σε κατάσταση πλήρους μαζικής παραγωγής, οπότε αναμένετε να οδηγούν σε ρεκόρ εσόδων και επιδόσεων τα επόμενα τρίμηνα.

Προϊόντα που αναφέρονται σε αυτήν την ανάρτηση

<!–

The links above are affiliate links. As an Amazon Associate, Wccftech.com may earn from qualifying purchases.

–>

VIA: wccftech.com